나만의 ChatGPT 만들기 - text-generation-webui

나만의 ChatGPT 만들기 - text-generation-webui

인터넷이 끊어져 있어도 나만의 ChatGPT 를 구현하는 방법을 알아봅니다.

text-generation-webui 를 이용하는 방법으로 정말 간단하게 나만의 ChatGPT 를 구축할 수 있습니다.

파일 다운로드

아래 깃헙 주소로 가서 전체 파일을 다운로드합니다.

https://github.com/oobabooga/text-generation-webui

GitHub - oobabooga/text-generation-webui: A Gradio web UI for Large Language Models. Supports transformers, GPTQ, AWQ, EXL2, lla

A Gradio web UI for Large Language Models. Supports transformers, GPTQ, AWQ, EXL2, llama.cpp (GGUF), Llama models. - oobabooga/text-generation-webui

github.com

실행

적당한 곳에 풀어놓고 cmd 창을 열어 아래 명령을 실행합니다.

저는 윈도우라서 아래 명령을 사용했지만 운영체제에 따라서 실행하시면 됩니다.

.\start_windows.ba

명령을 실행하면 구동에 필요한 패키지들을 다운로드하고 설치합니다.

진행하다 보면 아래와 같이 선택하는 창이 나오면 자신의 상황에 맞는 옵션을 선택합니다.

전 NVIDIA 를 선택했습니다.

아래의 화면에서는 N 을 선택했습니다.

여러 패키지들을 다운로드하기 때문에 시간이 좀 걸립니다.

아래와 같은 화면이 나오면 실행완료가 된 것입니다.

위 메시지를 보면 알 수 있듯이 아직 Model 파일이 설정되어 있지 않습니다.

UI 접속 및 Model 설정

해당 페이지로 들어가 봅니다.

Model 을 다운로드하여야 합니다 상단의 Model 메뉴를 선택합니다.

허깅페이스 사이트에서 모델명을 찾고 Download 를 클릭하여 모델을 다운로드합니다.

(upstage/SOLAR-10.7B-Instruct-v1.0 : https://huggingface.co/upstage/SOLAR-10.7B-Instruct-v1.0 )

다운이 완료되고 준비가 되면 아래와 같은 화면이 나옵니다.

다운이 완료되면 왼쪽화면 상단의 Model 선택에서 다운로드한 모델을 선택합니다.

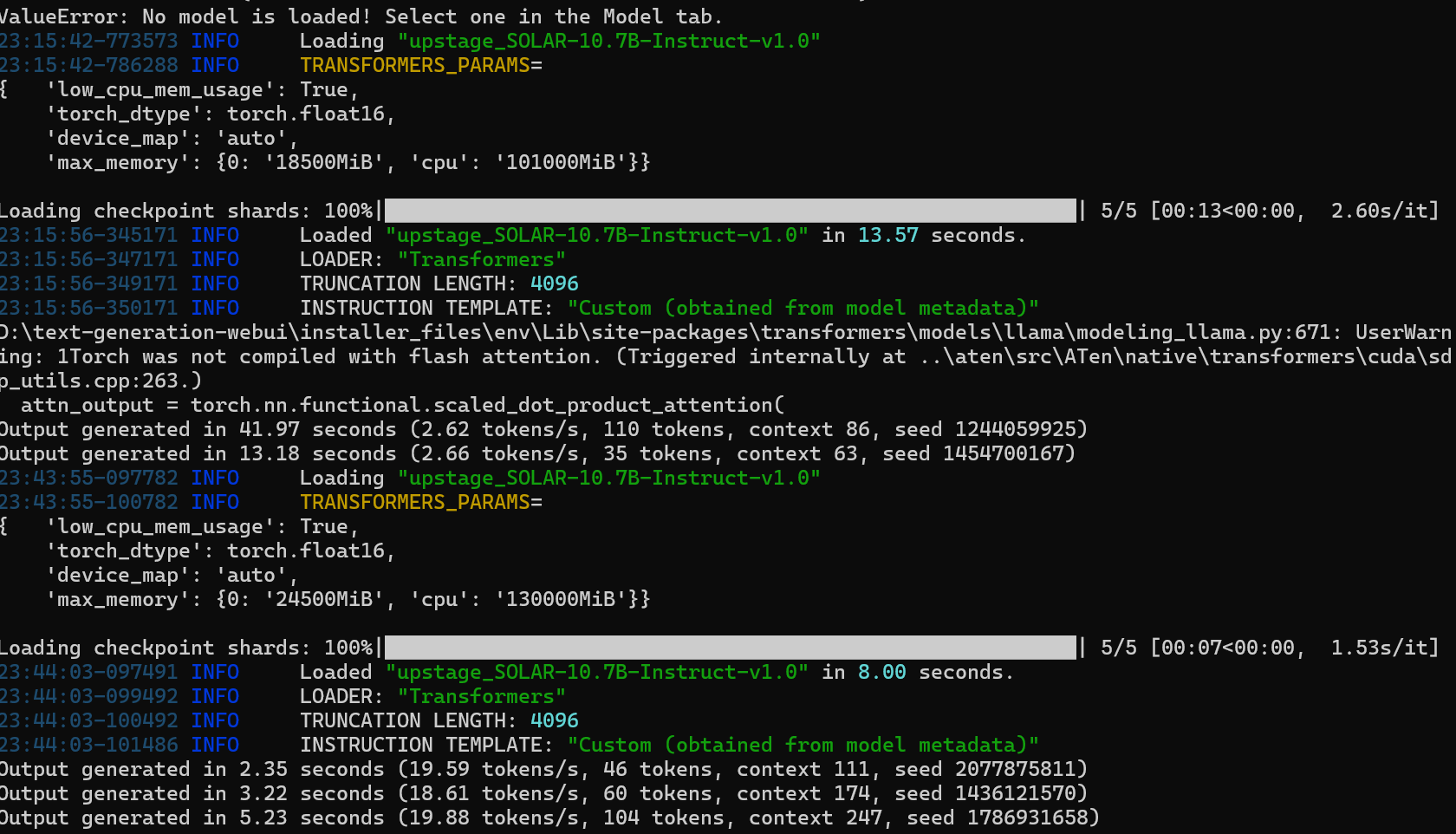

아래쪽에 사용할 gpu, cpu memory 를 설정하게 되어있는데 저는 적당해 높게 했습니다.

Model 선택 옆에 Load 버튼을 클릭합니다.

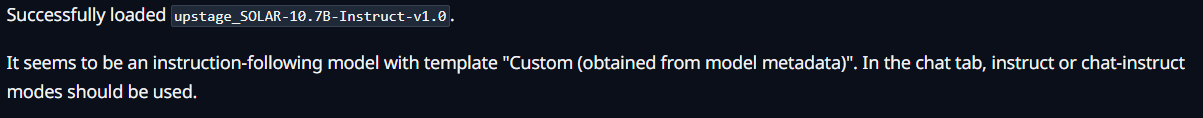

오른쪽 하단에 아래와 같은 메시지가 뜨면 Load 가 완료된 것입니다.

질문하기

이제 Chat 메뉴를 선택하여 대화를 해봅니다.

gpu 설정을 안 한 상태로 하면 답변이 상당히 느립니다. 하지만 gpu 를 최대 사용으로 하면 답변 속도가 빨라집니다.

cmd 창을 가서 보면 질문을 할 때마다 답변을 내기 위해 열심히 일하는 모습을 확인할 수 있습니다.^^

오프라인 상태에서도 질문이 가능하기 때문에 유용해 보입니다.

'코딩 > Python_AI' 카테고리의 다른 글

| OPENAI LLM 초간단 예제 (0) | 2024.06.19 |

|---|---|

| GPT4ALL 사용해 보기 (0) | 2024.06.16 |

| 로컬에서 Llama3-8B 모델 돌려보기 - Ollama (0) | 2024.06.15 |

| llama index 를 이용해 내가 가진 data 로 질문하기 - OpenAI (0) | 2024.06.11 |

| FastAPI index.html 시작 페이지로 만들기 (0) | 2024.06.11 |