LM Studio 에서 LLM 로컬 서버 띄우기

LM Studio 에서 LLM 로컬 서버 띄우기

허깅페이스에 가면 정말 많은 LLM 모델들이 있습니다.

이 모델들을 활용하여 로컬 서버에 나만의 gpt 서버를 구축하고 싶다면

LM Studio 를 이용하여 아주 쉽게 LLM 서버를 구축할 수 있습니다.

LM Studio 를 설치

먼저 LM Studio 를 설치합니다.

👾 LM Studio - Discover and run local LLMs

Find, download, and experiment with local LLMs

lmstudio.ai

위 사이트에서 프로그램을 다운로드하고 실행합니다.

실행하는 첫 화면은 아래와 같습니다.

LLM 모델 다운로드

LLM 모델들이 나열되어 있는데 이 중에서 원하는 걸 검색합니다.

아래처럼 검색결과가 나오는데 여기에서 아래처럼 되어있어야 사용이 가능합니다.

여기에서 아래처럼 초록색 글자가 있어야 사용이 가능합니다.

원하는 모델을 찾았으면 다운로드합니다.

모델 용량이 크니 자신의 컴퓨터 가용공간을 확인하고 다운로드하아야 합니다.

용량이 큰 만큼 시간이 오래 걸립니다.

AI 채팅으로 테스트하기

다운이 완료되면 AI Chat 메뉴를 클릭합니다. 좌측 3번째 아래 그림

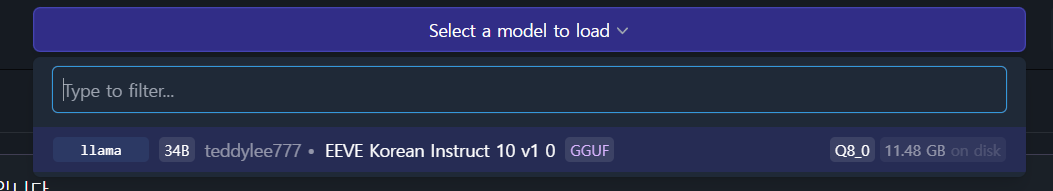

여기에서 상단에 Select a model to load 을 클릭해 다운로드한 모델을 선택합니다.

오른쪽에 Settings 에서 Preset 을 선택해 응답 Template 을 선택합니다.

이제 채팅창에 질문을 하게 되면 다운로드한 모델로 응답을 하게 됩니다.

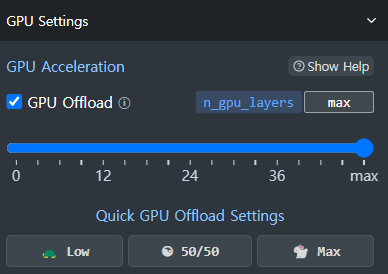

오른쪽 메뉴 중에 GPU Settings 에서 GPU 사용을 최대로 하게 되면

응답 속도가 더 빨라집니다.

서버 동작 하기

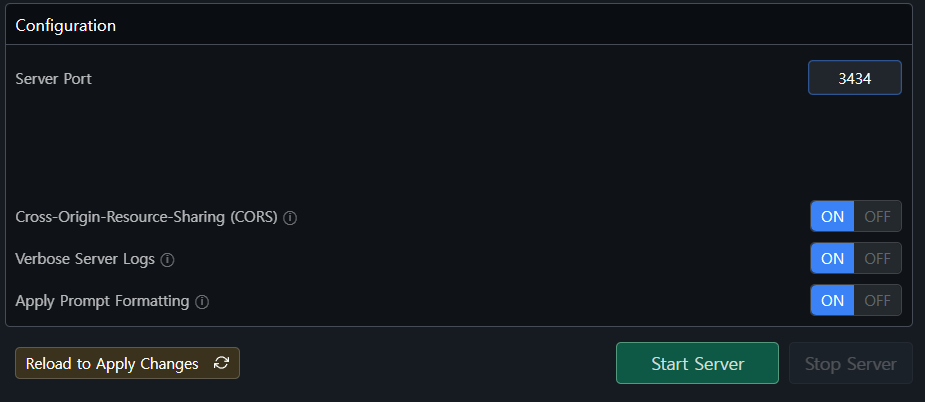

좌측 메뉴 중에 Local Server 를 선택합니다.

아래 Reload to Apply Changes 버튼을 클릭하여 변경사항을 저장하고 Start Server 를 클릭합니다.

만약 서버가 제대로 실행되지 않는다면 Server Port 를 변경해 봅니다.

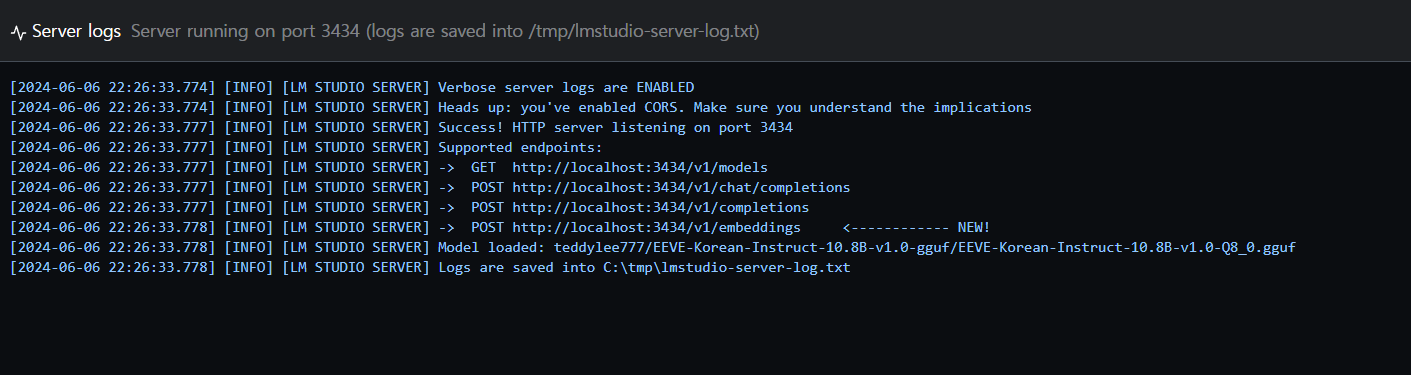

위처럼 로컬 서버가 동작이 된 걸 확인할 수 있습니다.

'코딩 > Python_AI' 카테고리의 다른 글

| .env 파일에서 OPENAI_API_KEY 처리하기 (0) | 2024.06.08 |

|---|---|

| LM Studio 서버로 나만의 LLM 채팅 서비스 제작하는 방법 (0) | 2024.06.08 |

| streamlit 으로 나만의 GPT 채팅 서비스 제작하는 방법 (0) | 2024.06.08 |

| Open API 사용을 위한 Key 발급 받기 및 요금 (0) | 2024.06.08 |

| streamlit 사용하기 (0) | 2024.05.30 |